一、引言:AGI的梦想与挑战

在人工智能领域,通用人工智能(AGI)代表着技术的终极梦想——创造出能够理解、学习并适应任何智力任务的智能系统。然而,这条探索之路充满了未知与挑战,稍有不慎便可能步入“不归之途”。本文将围绕如何合理规划AGI研发路径、识别潜在风险、以及建立伦理框架,提供一系列实用指南。

二、明确AGI的愿景与目标

2.1 设定清晰的研发里程碑

- 步骤概述:确立短期、中期、长期研发目标,确保每一步都朝着AGI的最终愿景迈进。

- 操作指南:

- 短期:聚焦于特定领域内的智能提升,如自然语言处理、图像识别等。

- 中期:尝试跨领域融合,实现多任务学习与协同工作。

- 长期:探索自我学习与自我优化机制,逐步逼近AGI。

- 注意事项:避免过度追求单一技术的突破,而忽视系统整体协调性与泛化能力。

2.2 引入跨学科视角

- 技巧提示:结合心理学、神经科学、哲学等多学科知识,深化对智能本质的理解。

- 案例分享:DeepMind的AlphaFold在蛋白质结构预测上的成功,得益于生物信息学与机器学习的深度结合。

三、构建稳健的技术基础

3.1 强化算法与模型的可解释性

- 重要性:提高AI系统的透明度,有助于识别并解决潜在的偏差与错误。

- 实践方法:采用LIME、SHAP等工具进行模型解释,同时探索基于符号逻辑与神经网络结合的混合模型。

- 注意事项:平衡可解释性与性能,避免过度牺牲准确性。

3.2 数据质量与多样性

- 策略建议:收集高质量、多样化的训练数据,确保模型能泛化到未见过的情境。

- 技巧窍门:利用数据增强技术,如图像翻转、文本同义改写,增加数据多样性。

- 常见问题:数据偏见可能导致模型歧视,需定期审查并调整数据集。

四、风险评估与伦理框架

4.1 识别AGI研发中的潜在风险

- 风险类型:就业冲击、隐私泄露、决策不透明、超级智能失控等。

- 评估工具:采用SWOT分析(优势、劣势、机会、威胁)识别风险点。

- 应对措施:建立风险预警机制,制定应急响应计划。

4.2 建立伦理指导原则

- 核心原则:尊重人权、公平性、透明度、责任可追溯。

- 实践指南:参考AI伦理准则(如阿西洛马原则),制定内部伦理审查流程。

- 案例分析:Google DeepMind因未能妥善处理医疗数据隐私而引发的争议,强调了伦理审查的重要性。

五、持续迭代与社区合作

5.1 鼓励开放科学与创新

- 行动倡议:发布开源框架、数据集,促进知识共享与技术交流。

- 合作平台:加入AGI相关的研究联盟,如OpenAGI,共同推进技术发展。

- 注意事项:保护知识产权的同时,积极贡献于全球科技共同体。

5.2 定期评估与反馈循环

- 评估机制:设立阶段性评估会议,邀请内外部专家参与评审。

- 反馈机制:建立用户反馈渠道,及时收集并响应需求变化。

- 持续改进:基于评估结果与反馈,不断优化技术路线与产品设计。

六、常见问题解答(FAQ)

Q1:AGI研发是否必然导致就业危机? A: 不一定。通过政策引导与技能培训,可以缓解就业结构变化带来的冲击。 Q2:如何确保AGI系统的决策公平性? A: 在设计初期就融入公平性考量,采用多样性数据集,实施偏见检测与缓解策略。 Q3:AGI研发过程中的伦理审查有多重要? A: 至关重要。它能有效预防技术滥用,保护个人隐私,维护社会公正。

结语

探索AGI的不归之途充满了挑战,但通过明确目标、构建稳健技术基础、积极应对风险、建立伦理框架,以及持续的迭代与社区合作,我们可以更加稳健地迈向这一科技前沿。记住,每一步探索都是向着更加智慧、更加美好的未来迈进的一小步。

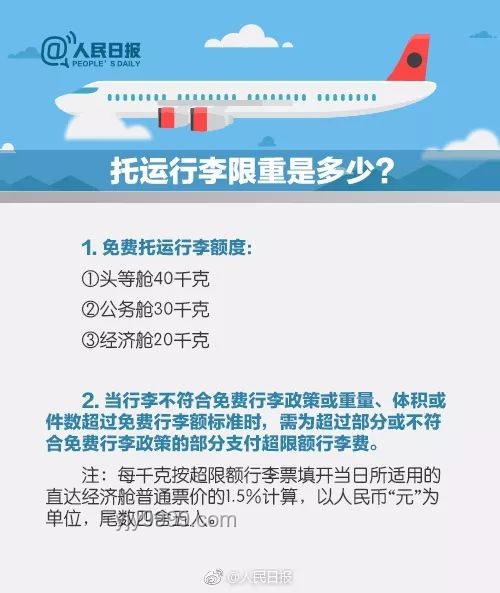

图:AGI探索路径示意图,展示了从短期目标到长期愿景的逐步推进过程。

图:AGI探索路径示意图,展示了从短期目标到长期愿景的逐步推进过程。

文章评论 (3)

发表评论